Früher war alles besser. Damals bemaß sich der Preis von Rohstoffen nach dem Verhältnis von Angebot und Nachfrage, wobei Ersteres tendenziell geringer und Zweitere dringender wurde. Heute kann man sich auf derart einleuchtende Faustregeln leider nicht mehr verlassen, die Welt ist nämlich unübersichtlich geworden, und der neue, heiße Rohstoff wird immer mehr und mehr, und niemand weiß so recht, was man damit eigentlich anfangen soll, aber dass in ihm das ganz große Geld steckt, darüber herrscht weitgehend Konsens. Das neue Öl sind Daten, und wer mit Daten umgehen kann, der kann so die Prognose nicht nur ordentlich Reibach machen, sondern, unter anderem, auch den Zufall ausschalten, die Zukunft vorhersagen und mit ein bisschen Geschick auch verändern. Daten sind nicht nur das neue Öl, sie sind der neue liebe Gott. Dessen Name: Big Data. Unter diesem Titel tummeln sich derzeit alle möglichen Heilserwartungen und -versprechen, die Welt wird mal wieder vom Internet aus verändert. Grundtenor: Wer heute nicht mit allem rechnet, ist schnell von gestern. Aber warum? Und was ist Big Data eigentlich?

Sehr viel Information

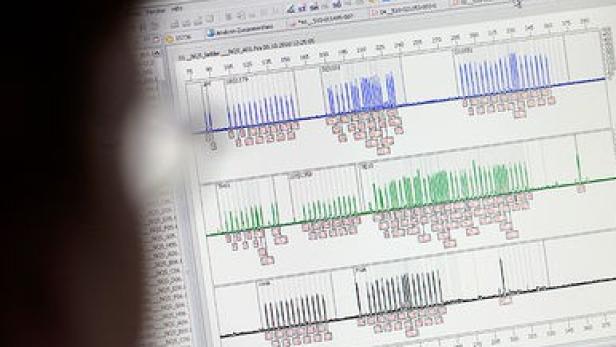

Im erster Linie ist Big Data, was der Name sagt: sehr viel Information. Laut der im Dezember veröffentlichten Digital Universe Study der International Data Corporation (IDC) wurden im Jahr 2012 weltweit etwa 2,8 Zettabyte Daten erzeugt und verbreitet, was 2,8 Trillionen Gigabyte entspricht. Das kann man sich, wenn man mag, als chinesische Mauer aus DVDs vorstellen, als Festplattenturm bis zum Mond oder als Stapel aus zigtausend Nationalbibliotheken, Hauptsache, man stellt sich sehr, sehr viele Daten vor, die auch noch ständig mehr werden. Bis 2020 soll laut IDC-Studie die jährliche Datenproduktion auf 40 Zettabyte steigen, also das Vierzehnfache des aktuellen Volumens. Derzeit werden, so die Datenzähler, nur 0,5 Prozent dieser Informationen nutzbringend ausgewertet, was auch daran liegt, dass Daten in diesem Zusammenhang wirklich alles Mögliche sind: Kreditkartentransaktionen, Motordrehzahlen, Wind- und Wetterdaten, Warenlagerlogistik, Facebook-Fotos, Überwachungskameravideos, Blogeinträge, Google-Suchen, GPS-Ortsangaben, Börsengeschäfte und Hotelbewertungen. Und so weiter, bis zum Mond und zurück. Allein aus Twitter-Feeds fallen täglich zwölf Terabyte Daten an. Jedes moderne Flugzeugtriebwerk ist ständig mit der Bodenzentrale verbunden und liefert pro Transatlantikflug mehr Informationen, als in einen handelsüblichen Großrechner passen.

Das mag rein quantitativ schon recht beeindruckend wirken, die neue Qualität von Big-Data-Anwendungen liegt aber anderswo. Nämlich in der Fähigkeit, mit diesen unstrukturierten, chaotisch veranlagten Informationen, die in kein Excel-Sheet passen, zu rechnen und dabei verschiedene Datenquellen übereinanderzulegen. Ein bereits klassisches Beispiel aus den USA: Ein Mann, verärgert, stürmt in eine Filiale der Supermarktkette Target in der Nähe von Minneapolis. Seine minderjährige Tochter hätte von dem Laden persönlich adressierte Werbung für Babynahrung und -zubehör erhalten. Frechheit! Wie man dazu komme? Der Filialleiter entschuldigt sich, ein paar Tage später meldet sich der Vater noch einmal, diesmal eher zerknirscht. Ihm sei inzwischen mitgeteilt worden, dass seine Tochter tatsächlich schwanger sei. Der Supermarkt hatte schon vor dem werdenden Opa Bescheid gewusst, weil er das Kaufverhalten seiner jugendlichen Kundin analysiert und eins und eins zusammengezählt hatte. Auch den Geburtstermin konnte der Supermarkt mit großer Wahrscheinlichkeit voraussagen, weil laut Statistik in den ersten Wochen eher Spurenelemente gekauft werden, im zweiten Schwangerschaftsdrittel Körperlotions und kurz vor der Geburt Wattebäusche und Desinfektionsmittel.

Wetterbedingter Einkauf

Gleiche Branche, anderes Beispiel: Weil unterschiedliche Wetterverhältnisse im Handel durchaus massive Umsatzschwankungen auslösen können, leistet sich die britische Supermarktkette Tesco einen eigenen Wetterdienst, der dreimal täglich mit den Lager- und Warenwirtschaftsdaten abgeglichen wird, um notfalls auch kurzfristig umzudisponieren. Denn bei Sonnenschein werden andere Produkte und andere Mengen verkauft als bei Nebel. Lagerstände, Rabatte und Werbeaktionen können heute tages- und stundenaktuell an die Witterung oder auch kurzfristige Konkurrenzangebote angepasst werden. Die österreichische Bäckereikette Ströck lässt sich ihre Absatzprognosen übrigens von dem ganz ähnlich gestrickten Anbieter Meteolytix erstellen. Der US-Handelsriese WalMart scannt zusätzlich auch noch Social-Media-Plattformen wie Facebook oder Twitter nach regionalen Trends oder unvorhergesehenen Ereignissen, die eine Markt- und Preisanpassung nötig erscheinen lassen. Die Strategie kommt aus dem Rechner, nicht aus dem Bauch des Verkaufsleiters.

Für den Big-Data-Experten Björn Bloching vom Unternehmensberater Roland Berger ist genau das der entscheidende Schritt: Die Ära der Intuition ist vorbei. Experten sind von gestern.

Big Data ist, wenn für den immer schneller anwachsenden Daten-Heuhaufen Röntgengeräte bereitstehen, die die Nadel auf Knopfdruck anzeigen. Big Data ist aber auch, wenn ein Computer schon so viele Heuhaufen gescannt hat, dass er gar nicht mehr röntgen muss, um zu wissen, wo die Nadel liegen sollte. Auf einmal wird unser gesamtes soziales Leben zahlenmäßig darstellbar, rechenbar und mit den richtigen Analysemodellen auch immer besser vorausberechenbar, sagt der Wiener Medienberater Rudi Klausnitzer, der dieser Tage ein Buch zum Thema präsentiert (Das Ende des Zufalls. Wie Big Data uns und unser Leben vorhersagbar macht, Ecowin Verlag). Big Data wird grundlegende Veränderungen für Politik, Finanzen, Wissenschaft, Forschung, Kommunikation und Alltag haben. Wobei die für mich überraschendste Erkenntnis war, wie weit wir in gewissen Branchen schon sind. Die Intensität, mit der gewisse Nischen schon mit Big Data durchdrungen sind, wird unterschätzt. Je vernetzter wir sind, desto größer ist das Ausmaß, in dem wir analysierbar sind und damit auch vorherberechenbar.

Aus simplen Transaktionen können Kreditkartenfirmen heute schon mit hoher Wahrscheinlichkeit voraussagen, ob sich ein Paar in den nächsten Monaten trennen wird. Dafür werden soziologische Studien mit Einkaufsdaten verschnitten und mit historischen Trends abgeglichen: Wenn eine Frau beginnt, sich selbst sehr viel Schmuck zu kaufen, deutet das auf baldige Trennung hin. Das lässt sich aus Erfahrung lernen, aber auch aus simpler Datenanalyse schließen: So war es schon in Tausenden Fällen vorher, also wird es auch im nächsten Fall wahrscheinlich so sein. Gott würfelt nicht. Und die Statistik wird zur halbgöttlichen Instanz. Wo der Zufall wegfällt, da wird das Schicksal wieder schlagend.

Zufall wird gestrichen

Beim 10. Internationalen Philosophen-Kongress in Amsterdam warnte Sir Karl Popper 1948 seine Kollegen eindringlich vor dem Versuch, menschliches Verhalten prophezeien zu wollen: Der Versuch der Sozialwissenschaften, Gesetzmäßigkeiten der historischen Entwicklung zu finden, um daraus zukünftige Entwicklungen vorherzusagen und damit der Gesellschaft und der Politik praktische Hinweise zu geben, welche Maßnahmen in Zukunft aller Wahrscheinlichkeit nach erfolgreich sein werden und welche nicht, ist zum Scheitern verurteilt. Das Scheitern, von dem Popper sprach, existiert nicht mehr. Mit den neuen Softwaremitteln können nicht mehr nur Kometenbahnen vorausberechnet werden, sondern auch, zum Beispiel, gewaltsame Aufstände oder Verkehrsunfälle. Der neue Dataismus macht sich daran, Ideologie und Vorurteile auszulöschen und den Zufall aus der Gleichung zu nehmen. Was gemessen werden kann, wird gemessen, und was errechnet werden kann, wird errechnet.

Wobei ein verbreitetes Missverständnis dem Zufall wieder auf die Bühne verhilft. Wenn Big Data Prognosen macht, dann errechnet es Wahrscheinlichkeiten. Es sagt keine Ereignisse voraus, sondern nur die Möglichkeit ihres Eintretens. Diese Wahrscheinlichkeiten wiederum werden aus statistischen Mustern errechnet. Und das kann unter Umständen auch ganz schön in die Irre führen. Anthony Goldbloom vom Big-Data-Portal Kaggle, auf dem vor allem statistische Rechenaufgaben zur Bearbeitung freigestellt werden, erzählt in Interviews gern von seinem Lieblingsprojekt: Ein US-Gebrauchtwagenhändler wollte wissen, welche Fahrzeugmodelle am langlebigsten seien. Das Ergebnis der Kaggle-Rechner fiel erfrischend kontraintuitiv aus: Weder die gefahrenen Kilometer noch die Motorbauart geben demnach den Ausschlag für ein langes Autoleben, sondern eine ungewöhnliche Farbe. Warum? Man weiß es nicht. Aber die Daten ergeben diese Korrelation nun einmal ganz eindeutig. Dass hinter dem Zusammenhang reiner Zufall steckt, ist klar und einer der Pferdefüße jeder Big-Data-Euphorie. Der US-Statistiker Nate Silver, seit seinen höchst erfolgreichen Wahlkampfprognosen der Superstar der Dataisten, bleibt einer ihrer größten Kritiker (siehe Infobox am Ende). Dateneuphoriker, so schreibt Silver in seinem aktuellen Bestseller The Signal and the Noise, tendieren dazu, das Rauschen mit dem Signal zu verwechseln: Die Zahlen sprechen nicht für sich. Wir sprechen für sie. Wir verleihen ihnen eine Bedeutung. Mit der Menge der verfügbaren Daten steigt nicht die Menge der Kausalketten, sondern bloß die Wahrscheinlichkeit, zufällige Übereinstimmungen für solche zu halten. Der Chefredakteur des Technologiemagazins Wired, Chris Anderson, postulierte schon vor vier Jahren, dass in der Ära von Big Data keine wissenschaftliche Methode mehr vonnöten sei, keine Hypothesen und Tests, sondern bloß noch Datenanalyse, Mustersuche, Simulation. Jeder Zusammenhang ist wichtig, auch wenn keine Kausalität dahintersteckt.

Daten entwickeln ein Eigenleben

Der große Unterschied zu gestern: Daten entwickeln ein Eigenleben, meint Klausnitzer. Sie werden nicht mehr nur für den Urzweck verwendet, für den sie eigentlich gegeben wurden. Daten leben, wandern und werden akkumuliert. Dann werden sie wiederaufbereitet, ausgetauscht und mit anderen Daten kombiniert. Das neue Öl wird raffiniert und raffinierter. Klausnitzer weiter: Das Problem dabei: Es werden Wahrscheinlichkeiten berechnet oder genauer gesagt Muster, die eine erhöhte Wahrscheinlichkeit für ein bestimmtes Verhalten erwarten lassen. Das bedeutet, dass man sehr schnell zum Vor-Betroffenen werden kann. Man hat noch keine Krankheit, aber man gehört zu denen, die eine höhere Wahrscheinlichkeit aufweisen, sie zu bekommen. Die Rasterfahndung, die früher maximal ein staatliches Mittel im Notfall war, ist der Normalzustand.

Das ist selbst dort heikel, wo tatsächlich Polizeiarbeit geleistet wird. Das Police Department von Memphis, Tennessee, arbeitet schon seit 2006 mit dem vom Kriminologen Richard Janikowski entwickelten Programm BlueCrush, das aus den Kriminaldaten der Stadt auf zukünftige Gefahrenquellen hochrechnet und daraus konkrete Einsatzpläne erstellt. Das Prinzip heißt Predictive Policing und könnte mit gutem Willen als Verbrechensprävention bezeichnet werden. Der Schritt zum Ethnic Profiling ist freilich ein kleiner. Die Zahlen kennen zwar keine Vorurteile, haben aber eben auch gar kein Gespür für Moral.

Auch Versicherungskonzerne setzen große Stücke auf Big Data. Je tiefer die Analyse, desto gefinkelter die Risikoabwägung. Beim Big-Data-Portal Kaggle läuft derzeit ein von dem US-Krankenversicherer Heritage ausgeschriebener Wettbewerb: Finde den Algorithmus, der mit der höchsten Wahrscheinlichkeit voraussagen kann, welcher Patient im nächsten Jahr ins Krankenhaus gehen und wie lange er dort bleiben wird. Preisgeld: drei Millionen Dollar. Natürlich wird der Algorithmus keinen einzigen Krankheitsfall mit Sicherheit prophezeien können. Aber er wird eine Zahl ausspucken, und wenn sie hoch genug ausfällt, wird die Krankenversicherung sich möglicherweise gezwungen sehen, dem entsprechenden Kunden einen Brief zu schreiben. Längst in Arbeit sind auch Ad-hoc-Policen, etwa für Autoversicherungen, deren Prämie jeweils aktuell auf das Wetter, die Uhrzeit, die Anzahl der Fahrgäste oder die Route abgestimmt ist. Risiko wird dank Big Data immer feiner berechenbar. Und unter Umständen unleistbar und sei es das Risiko, bei Regen noch einmal das Haus zu verlassen oder das Auto in einer dunkleren Seitengasse zu parken.

Der aus Österreich stammende Harvard-Professor und Datenschutzexperte Viktor Mayer-Schönberger warnt vor einem Zustand, in dem wahrscheinliches Verhalten tatsächliche Nachteile mit sich bringt: Voraussagen über menschliches Verhalten könnten in Strafen resultieren, die die Regelverletzung vorwegnehmen. Oder, auch das ist im Portfolio vieler Big-Data-Anbieter bereits angelegt, das vorausgesagte Verhalten wird subtil in eine andere Richtung gedrängt. Der Konsument im Onlineshop reagiert auf die Vorschläge des Algorithmus, der Benutzer von Fitness-Apps läuft den Vorgaben des Programms hinterher. Gerade im Gesundheitssystem werden große Hoffnungen auf dieses Prinzip gesetzt. Das britische Gesundheitsministerium hat zuletzt 500 verschiedene Fitness- und Ernährungs-Apps zur freien Verfügung gestellt in freudiger Erwartung von Milliardeneinsparungen.

Im Vorjahr verabschiedete der US-Präsident Obama die Big Data Research and Development Initiative, in deren Rahmen sechs Ministerien mehr als 200 Millionen Dollar in die Datenforschung investieren. Neben dem Gesundheitsressort stand an erster Stelle das Pentagon, das noch einmal 250 Millionen Dollar pro Jahr drauflegt. Das Ziel: digitale Geheimdienstarbeit sowie, laut Ausschreibung, Nutzbarmachung und Verwendung großer Datenmengen und Verknüpfung von Wahrnehmungs- und Entscheidungshilfen zur Herstellung von echt autonomen Systemen, die unabhängig manövrieren und Entscheidungen treffen können. Das klingt nicht nur dann unheimlich, wenn man bedenkt, dass Algorithmen die Tendenz zum Durchdrehen in sich bergen. Man kennt das Phänomen aus der Finanzwelt (die schon jetzt weitreichend von Big-Data-Analysen und -Prognosen abhängig ist): Am 6. Mai 2010 stürzte der Dow Jones innerhalb von wenigen Minuten um dramatische zehn Prozent ab. Erst Wochen später wurde offenkundig, was hinter dem unerklärlichen Flash Crash steckte: Verkaufsalgorithmen, die sich im Hochfrequenzhandel gegenseitig und unkontrolliert in die Tiefe geschraubt hatten.

Wir haben unsere Beobachtungs- und Entscheidungsfunktionen in vielen Fällen in maschinenbasierte Systeme ausgelagert und sie so schnell und effizient gemacht, dass sie sich unserer Kontrolle weitgehend entziehen, sagt Rudi Klausnitzer, der nicht nur aus diesem Grund auf einen New Deal für Daten drängt einen juristisch abgesicherten gesellschaftlichen Konsens, wie mit Daten und Algorithmen umzugehen sei. Die vom EU-Parlament für nächstes Jahr angestrebte Datenschutzrichtlinie könne dabei nur ein erster Grenzstein sein. Der Geist ist aus der Flasche. Wir müssen einen Konsens finden, wie wir damit umgehen. Wir müssen Grenzen einziehen, deren Übertretung Konsequenzen hat. Wirklich anonymisierte Daten müssen offen sein. Aber der Versuch, sie zu reidentifizieren, muss strafbar sein. Wenn das nicht gelingt, bekommen wir schon in den nächsten Jahren eine waschechte Bürgerrechts-Auseinandersetzung.

Das war übrigens eine Prognose, die nicht aus der Datenbank stammt.

Infobox I

Was Big Data kann: vier Beispiele

Windräder aufstellen

Der dänische Windkraft-Anbieter Vestas kann dank Big-Data-Analysen für jeden gewünschten Standort innerhalb weniger Stunden eine detaillierte Ertragsprognose abgeben. Dafür werden unter anderem historische Klima- und Wetterdaten, Maschinenkennzahlen, Satellitenbilder und Wartungslogbücher eingerechnet.

Geheimdienst modernisieren

Big Data zählt zu den großen neuen Hobbys der CIA. In die Start-ups Recorded Future und Palantir hat der Geheimdienst bereits mehrere Millionen Dollar investiert. Deren Aufgabe: Informationen aus Weblogs, Social Media, Regierungsdaten und etlichen weiteren Quellen in ein sinnvolles Verhältnis zueinander zu setzen und daraus Situations- und Verhaltensprognosen zu erstellen.

Einkäufe vorausberechnen

Für die britische Supermarktkette Tesco richtete die Agentur Dunnhumby einen Big-Data-Wettbewerb aus: Das gesammelte Einkaufsverhalten von 100.000 Kunden wurde anonymisiert bereitgestellt, die Aufgabe bestand darin, den Zeitpunkt und den Umsatz des jeweils nächsten Einkaufs vorherzusagen. Der Preis ging an den russischen Mathematiker Alexander Dyakonov, dessen Algorithmus die Trefferquote der alten Tesco-Einkaufsprognose um 200 Prozent verbesserte.

Fieber messen

Mit seinem Webservice Flu Trends erzielte Google einen der bekanntesten Big-Data-Prestigeerfolge: Suchanfragen aus 25 Ländern werden nach Kriterien gefiltert, die auf eine Ausbreitung von Grippeerkrankungen hindeuten. Liegt das Ergebnis über dem historischen Durchschnitt, schlägt Flu Trends Alarm und kam mit der Ansage von Grippewellen den US-Gesundheitsbehörden schon mehrfach deutlich zuvor.

Infobox II

Musterschüler

Nate Silver ist der Vorzeigestatistiker der Big-Data-Bewegung. Und deren größter Skeptiker.Im Jänner 2009 wagte Hal Varian, Googles Chefökonom, eine Prophezeiung: Ich sage immer, Statistiker zu sein wird der sexy Job der nächsten zehn Jahre. Die Leute glauben, ich mache Witze. Aber wer hätte geglaubt, dass Computeringenieur ein sexy Job der 1990er-Jahre wird? Und wer hätte geglaubt, dass das Paradebeispiel so schnell gefunden werden würde? Es heißt Nate Silver, stammt aus Michigan, ist gerade 35 geworden und so etwas wie der Musterschüler der Datenwissenschaft. Das Time-Magazin erklärte ihn schon 2009 zu einer der 100 einflussreichsten Personen der Welt, Forbes zählte ihn ein Jahr darauf sogar zu den mächtigsten Menschen der Welt, was vielleicht eine Spur übertrieben war, denn wirklich phänomenal berühmt wurde der studierte Wirtschaftswissenschafter erst im vergangenen Herbst, als er in seinem New York Times-Blog die Umfragen zur US-Präsidentschaftswahl begleitete, das Ergebnis punktgenau prognostizierte und mit dem Buch The Signal and the Noise den erstaunlichsten Bestseller des Jahres ablieferte: Einen 500-Seiten-Wälzer über Statistik und Wahrscheinlichkeitsrechnung, der sich rasend verkaufte. In dem tatsächlich sehr unterhaltsamen Buch erläutert Silver unter anderem, wie Statistiken den Baseballsport verändert haben (er selbst war daran nicht ganz unbeteiligt), wie er beim Pokern zigtausend Dollars gewann und warum Wirbelstürme leichter vorherzusagen sind als Erdbeben. Im Bezug auf Big Data bleibt er trotzdem skeptisch. Riesige Datenmengen maschinell nach Mustern zu durchsuchen reiche nicht aus, um gute Voraussagen zu treffen, sagt Silver. Ohne Kontext und Evaluation seien Statistiken sinnlos, weil voller Zufallsergebnisse. Big Data needs Big Judgment, sprich: Es braucht immer auch den menschlichen Faktor. Also Leute wie Nate Silver.

Bücher

Das Ende des Zufalls. Wie Big Data uns und unser Leben vorhersagbar macht; Ecowin; EUR 21,90 (gebundene Ausgabe)

Nate Silver:The Signal and the Noise:

Why So Many Predictions Fail but Some Dont

Penguin Press HC; EUR 16,95 (gebundene Ausgabe)