Gefilterte Information: Wie Facebook widersprüchliche Meinungen aussortiert

Es ist sehr einfach, im Internet Tag für Tag Selbstbestätigung zu erhalten. Ein FPÖ-Sympathisant beispielsweise, der ein tiefes Unbehagen gegenüber Asylwerbern verspürt und glaubt, vom riesigen staatlichen Kuchen bekäme er nur die Brösel ab, wird im Internet Gehör und Gleichdenkende finden. Er klickt bei der Facebook-Site von Heinz-Christian Strache auf "Gefällt mir“ und erfährt mehrfach am Tag, wie die Österreicher im eigenen Land behandelt werden. Zum Beispiel blendet ihm Facebook die Strache-Botschaft ein, dass eine "Asylantenfamilie“ fürs "Nichtstun“ 32.000 Euro vom Staat bekommen würde und somit mehr als vergleichbare österreichische Familien (das stimmt nicht). Oder dass die Erhöhung der staatlichen Entwicklungshilfe ein Unsinn sei, schließlich gebe es doch in Österreich "Rekordarbeitslosigkeit“ (von den Ertrinkenden im Mittelmeer kein Wort).

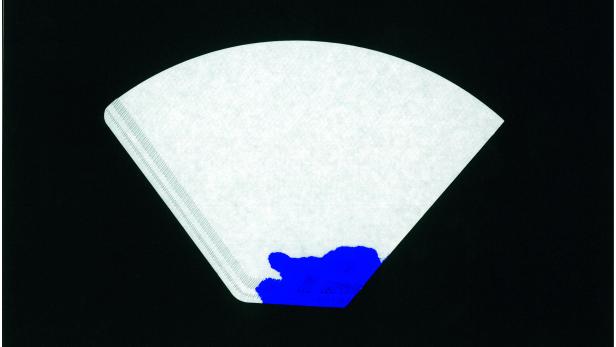

Dieses Phänomen - Menschen lassen sich online gezielt Information nach ihrem Geschmack servieren - wird als " Filterblase“ bezeichnet. Im Internet mehr noch als in traditionellen Medien ist starke Filterung möglich. User können Andersdenkende per Mausklick blockieren, ein Feature, das im Alltag nicht eingebaut ist, und feinkörnig festlegen, wessen Information sie beziehen.

Facebook und "faktenschwache Argumente"

"Von allen Parteien in Österreich nutzt die FPÖ den Effekt der Filterblase am stärksten. Das ist kein Wunder. Gerade Parteien, die eher faktenschwache Argumente liefern, müssen versuchen, ihre Sympathisanten von einer Debatte mit stärkeren Argumenten abzuschotten“, sagt der Politik- und Digitalberater Yussi Pick. Deswegen betreibe die FPÖ Kanäle wie "FPÖ TV“ auf YouTube und pflege minutiös den Facebook-Auftritt ihres Parteichefs. Mit mehr als 225.000 Likes ist Strache der erfolgreichste österreichische Politiker auf Facebook.

Wie schlimm ist diese digitale Abschottung wirklich? Und wie undurchdringlich ist die Filterblase? Facebook hat laut eigenen Angaben 1,4 Milliarden monatlich aktive User, laut der Website Socialmediaradar.at sind 3,4 Millionen Österreicher auf dem sozialen Netzwerk.

Eine Studie von Facebook selbst behauptet, die Filterblase sei ein überschätztes Phänomen. Drei Angestellte des Internetkonzerns, sogenannte "Data Scientists“, haben die Daten von 10,1 Millionen amerikanischen Facebook-Usern analysiert und auch überprüft, ob Facebook kontroverse Meinungen ausblendet. Sie kommen in der Fachzeitschrift "Science“ zum Schluss: Die Filterblase sei kleiner als angenommen. Bei liberalen Usern blendet Facebook demnach nur acht Prozent der ihnen widersprechenden Nachrichten aus, bei Konservativen fünf Prozent.

Zur Erklärung: Viele User mögen sich dessen nicht bewusst sein, aber Facebook zeigt ihnen nicht alle Beiträge von Freunden und gelikten Sites an. Ein Computeralgorithmus - also eine komplex programmierte Software - entscheidet, was für den einzelnen User relevant ist. Zum Beispiel werden eher Postings von Freunden und Sites eingeblendet, auf deren Links man häufig klickt.

Die "Es ist nicht unsere Schuld"-Studie

Die Facebook-Studie sorgte für Furore. Nicht, weil sie die These der Filterblase tatsächlich widerlegte. Im Gegenteil: weil viele Formulierungen und das gesamte Untersuchungsdesign einigen Wissenschaftern nicht behagen. "Ich nenne es die ‚es ist nicht unsere Schuld‘-Facebook-Studie“, meint Christian Sandvig, Forscher der University of Michigan. Er war einer der Ersten, die die Interpretation der gesammelten Daten hinterfragten - und ihre Aussagekraft.

Für ihr Sample etwa sahen sich die Studienautoren keinen repräsentativen Querschnitt der Facebook-Mitglieder an, sondern ausschließlich User, die auf ihrem Profil eine eindeutige politische Überzeugung (etwa als "konservativ“ oder "liberal“) eingetragen hatten und sehr oft online sind. Nur vier Prozent der amerikanischen Facebook-User erfüllten die Kriterien, ein winziger und überdurchschnittlich politischer Ausschnitt. Selbst bei diesem ungewöhnlichen Sample mussten die Forscher feststellen, dass Facebook die Entstehung der Filterblase ein Stück weit fördert - zumindest im einstelligen Prozentbereich sortiert der Algorithmus Nachrichtentexte aus, die nicht dem Weltbild des Users entsprechen. "Unsere Arbeit legt nahe, dass Menschen in sozialen Medien mehr gegensätzlichen Diskursen ausgesetzt sind, als sich dies manch einer in seiner digitalen Realität ausmalte“, schreiben die Studienautoren in "Science“. In anderen Worten: Die Facebook-Mitarbeiter kommen zum Schluss, dass Facebook nicht so schlimm ist wie manch Horrorszenario behauptet hatte.

Die Studie ist, trotz ihrer facebookfreundlichen Formulierungen, auch für die heimische Politik interessant: Zwischen den Zeilen lässt sich herauslesen, wie es zu einer schrittweisen Entstehung der Filterblase kommt.

Schritt 1: User posten mehrheitlich Links zu Zeitungsartikeln, die ihre Meinung bekräftigen. Schritt 2: Facebook sortiert dann einen (laut Studie nur kleinen) Teil dieser kontroversen Links aus. Schritt 3: Am Ende zeigt sich auch noch, dass die Internetnutzer seltener auf Artikel klicken, die ihre Meinung herausfordern.

Zunehmend radikalisierte politische Debatte?

Die Veröffentlichung der Studie führte in den USA nun erst recht zu einer Debatte über die Größe der Filterblase und ihre Gefahren. Die Anhänger der Filterblasen-Theorie fürchten, dass ein zunehmendes Ausselektieren von anderen Meinungen zu einer zunehmend radikalisierten politischen Debatte führt. "Unsere Demokratie baut darauf auf, dass wir mit anderen Meinungen konfrontiert werden“, meint etwa Forscher Sandvig zu profil.

Natürlich war es auch vor Erfindung des Webs möglich, einseitige Information zu beziehen, etwa über Parteizeitungen. Aber im Netz haben es Politiker nicht nötig, journalistische Mittelsmänner zu engagieren - sie können viel direkter und rascher ihr Publikum ansprechen. Journalistische Kriterien spielen beim Facebook-Algorithmus auch keine Rolle.

Beispiel FPÖ: Immer wieder postet Heinz-Christian Strache Fälle, in denen Migranten in Österreich angeblich besser als der Rest der Einwohner behandelt würden - dass vieles davon gar nicht stimmt, sehen seine Fans im Facebook-Stream mitunter nicht. In ihre Filterblase dringt die Falschmeldung, aber nicht deren Korrektur - denn FPÖ-kritische Seiten haben sie ja nicht abonniert.

Auch im kleinen Österreich, weit entfernt vom amerikanischen politischen Diskurs und dem Fachstreit unter Forschern, kann man interessante Schlüsse aus dieser Studie ziehen - trotz ihrer begrenzten Aussagekraft. Zwei Zahlen illustrieren, wie sehr Facebook eine bunte Wohlfühlplattform und kein politisches Medium ist. Von den geteilten Weblinks, welche die Forscher in ihrer Studie analysierten, waren nur 13 Prozent sogenannte "harte“ Nachrichtentexte - in denen es zum Beispiel um Politik und nicht um Katzenfotos ging. Und ganz generell schienen die beobachteten User eher "softe“ Themen anzusteuern: Sie klickten nur auf sieben Prozent der Links, die zu harten Nachrichten führten.

Dies alles ist ein Teil der Erklärung, warum die FPÖ mehr als jede andere Partei im Netz reüssiert: Die Rechtspopulisten tun sich leichter, lockere Comics, Tierfotos oder Musikvideos mit dem Spitzenkandidaten zu posten als jene Politiker, die staatstragend oder zumindest seriös auftreten wollen.

Wer unernst bleibt, gewinnt. Forscher tappen trotz dieser Studie weiterhin im Dunklen, wie groß nun der Filter-Effekt wirklich ist. Sicher scheint zumindest: In der Facebook-Blase kommen Katzenbilder besser an als komplexe politische Debatten.